你敢信? GPT-5的电脑操作水平只比人类低2%了

机器之心报道

机器之心编辑部

Agent(智能体)是最近一段时间的人工智能热点之一,将大语言模型的能力与工具调用、环境交互和自主规划结合起来,使其能够像虚拟助理一样完成复杂任务。

其中「计算机使用智能体」(computer-useagent,CUA)是一种能够直接在电脑环境中代替人类执行操作的智能体。它和传统的对话式AI不同,不只是回答问题,而是模拟人类使用鼠标、键盘和操作软件来完成任务。在该领域,SimularResearch推出的框架AgentS是典型代表之一。

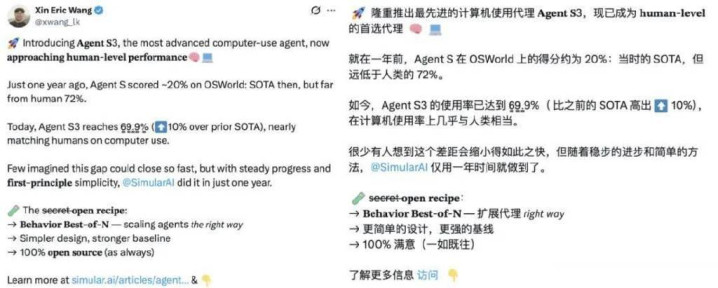

一年前,AgentS在CUA基准测试「OSWorld」上取得了20.6%的成绩。此后能力继续扩展,AgentS2将业界水平提升到了48.8%。就在昨日,AgentS3又刷新了自身记录,将性能拉升到了69.9%,超出先前的SOTA10%,接近人类水平的72%。

加州大学圣巴巴拉分校助理教授、Simular研究负责人XinEricWang表示,「接下来是超越人类的计算机使用」。

在技术层面,AgentS3直接在AgentS2的基础之上构建,通过简化框架并引入原生的代码智能体,将OSWorld上的性能提升至62.6%,实现了新的SOTA。

不仅如此,AgentS3还首次引入了并行扩展的CUA框架——BehaviorBest-of-N(bBoN),它不再依赖单次智能体运行,而是从多次rollout(执行过程)中挑选最佳结果。这种方法解锁了可扩展的性能提升,使准确率从62.6%提高到69.9%,并展示了智能体框架如何仅凭借扩展多样化运行次数,就能获得持续改进。

目前,AgentS3已经放出了相关论文,并且完全开源。

论文标题:TheUnreasonableEffectivenessofScalingAgentsforComputerUse

代码地址:https://github.com/simular-ai/Agent-S

接下来看AgentS3的技术和实验细节。

方法改进

计算机使用智能体(CUA)描绘了这样一个未来:软件自己运行,帮你订票、填写表格、操作应用,而你无需亲自动手。

但在当下,即便是最强的CUA,在任务变得冗长复杂时也常常出错。一次误点、一次延迟响应,或者一个意外的弹窗,都可能让整个执行过程偏离轨道。小错误会不断叠加,本该顺畅的自动化最终变成了挫败感。

这正是CUA面临的核心瓶颈:高方差(即高波动性)。同一个智能体,可能这一次顺利完成任务,而下一次却完全失败。这种不一致性让CUA难以预测,也凸显了在复杂、日常工作流中实现可靠性的巨大挑战。

缓解这种脆弱性的一个自然方法是并行扩展(WideScaling):与其简单地接受单个智能体的一次执行结果,不如扩大智能体数量,让它们并行生成多个执行过程,再从中选择最佳结果。

这种并行扩展的思路利用了一个事实:尽管单个智能体往往不够理想,但它们通常会在不同的任务子集上互补成功。不过,对CUA进行规模扩展也带来了独特的挑战。

长时间跨度的执行轨迹信息密度极高,且包含多模态细节,其中大多数与任务成功无关,这使得轨迹的表示、理解和比较变得困难。同时,评估本身也并非易事:许多计算机使用任务本身存在多种有效解法,而自动化评估往往难以判断某条轨迹是否真正正确。

因此,要实现对CUA的有效并行扩展,需要全新的应对方法:

在紧凑编码长轨迹的同时,保留与任务相关的语义;

可靠地评估多样化的解题路径,从而识别出成功的执行结果。

针对此,AgentS3引入了BehaviorBest-of-N(bBoN)来实现CUA的并行扩展,包括以下两个关键组件:

(1)行为叙事生成(BehaviorNarrativeGeneration)

本文的方法从生成事实开始。原始的智能体运行包含大量逐步的细节,其中许多无关紧要或冗余。通过生成「事实」,将这些嘈杂的运行过程转化为简洁的陈述,只关注那些与任务成功直接相关的信息。而将这些事实串联起来,就形成了一个「行为叙事」,它清晰地总结了智能体在每一步的操作,使其运行过程更加可解释,也更易于比较。

(2)行为最佳选择评判(BehaviorBest-of-NJudge)

在得到行为叙事后,进一步应用评判机制来决定哪一次运行最能完成任务。与直接比较原始输出不同,评判过程基于每个行为叙事中的事实进行决策。通过跨运行引用这些事实,评判者可以进行对比推理,从而判断哪一次尝试最为有效,并最终选出最佳执行结果。

另外,上个版本AgentS2采用了管理者—工作者(manager–worker)分层结构。但是随着基础模型的增强,这种层级反而成了不必要的开销。

因此,AgentS3对框架进行了精简,移除了这一层级结构,并引入了一个原生代码智能体,能够直接生成和执行代码。这样不仅让解决方案更加多样,既能处理代码任务,也能覆盖图形界面(GUI)任务,同时可靠性也得到了提升。

这些改进共同带来了约13%的性能提升,使AgentS3在单次运行上的表现达到62.6%,刷新当前SOTA。

实验结果

在改进基线的基础上,本文的核心贡献BehaviorBest-of-N(bBoN),在GPT-5上实现了69.9%的成功率(SR),相比AgentS3的单次运行提升了7.3个百分点;在GPT-5Mini上实现了60.2%的成功率,提升幅度为10.4个百分点。

考虑到人类的表现大约为72%,这些结果凸显了bBoN不仅大幅超越了现有方法,而且已经接近人类水平的能力。

此外,本文还在单次运行设定(不使用扩展)下,将AgentS3与AgentS2进行了对比。结果显示,BehaviorBest-of-N带来了13.8%的成功率提升,使每个任务的LLM调用次数减少了52.3%,平均任务完成时间缩短了62.4%。因此,AgentS3不仅能力更强,而且效率更高。

增加智能体运行次数实现扩展

在OSWorld上,本文发现随着智能体运行次数的增加,性能会逐步提升。当并行运行10次智能体时,性能达到最高:GPT-5的表现为69.9%,GPT-5Mini的表现为60.2%。

如何选择混合模型集成?

bBoN可以在不同模型之间扩展。下表展示了bBoN在使用不同混合模型组合时的成功率和任务覆盖率。任务覆盖率的计算方式是:只要在某个任务中至少有一条轨迹正确,就认为该任务成功,即Pass@N。

观察结果如下:

GPT-5+Gemini2.5Pro的组合实现了66.7%的最高成功率和78.0%的任务覆盖率,这表明选择由能力互补且多样化的模型构成的混合模型集成,可以获得最佳性能,并将上限提升到最高。

最具多样性的混合(All)相比任何单模型组合,取得了更高的任务覆盖率(75.4%),这证明了多样性是提升成功率上限的关键。

再次强调,GPT-5+Gemini2.5Pro的混合组合不仅实现了最高的成功率(66.7%),任务覆盖率也达到了78.0%,说明模型的多样性选择能够带来最优表现和最高上限。

行为叙事与其他轨迹表示的对比

本文对行为叙事表示进行了消融实验。对比对象包括:

仅截图基线

简单描述基线(即对每张截图单独生成描述)

结果表明,行为叙事在bBoN中是一种更有效的表示方式,相比最佳基线提升了3.4%。这说明仅依靠截图难以充分理解任务过程,而有必要在状态转变之间生成事实,而不是仅仅描述单一状态。

评判器对比

本文对bBoNJudge和WebJudge进行了对比。其中对WebJudge进行了修改,使其能够在多个轨迹中进行选择,方法是对轨迹进行独立排序,并选出排名最高的。

总体而言,bBoNJudge的表现优于WebJudge;而WebJudge相比单纯的多次运行平均性能,只带来了有限的提升。另外,随着运行次数的增加,bBoNJudge的扩展性表现更好。

评判器与人类的一致性

本文考察了评判器可能提升性能的任务(占OSWorld的44%),结果发现评判器在78.4%的任务上做出了正确选择。进一步复核后发现:评判器实际上在92.8%的任务上是正确的,这意味着OSWorld的真实性能更接近76.3%。

这一结果表明,评判器与人类偏好具有较高的一致性,使其成为评估CUA任务的一个颇具前景的工具。

更多实验结果请参阅原论文。